Компанії зі сфери штучного інтелекту прагнуть дізнатися думки вашого чат-бота — і це може стосуватися й вас

Коротко

- Більше ніж 40 провідних дослідників у галузі штучного інтелекту запропонували стежити за “ланцюгом мислення” чат-ботів, щоб виявляти шкідливі наміри до того, як вони стануть діями.

- Експерти з питань конфіденційності попереджають, що моніторинг цих внутрішніх процесів може викрити чутливі дані користувачів і створити нові ризики спостереження та зловживань.

- Дослідники та критики погоджуються, що необхідні строгі запобіжники і прозорість, щоб уникнути загроз конфіденційності від цього інструменту безпеки.

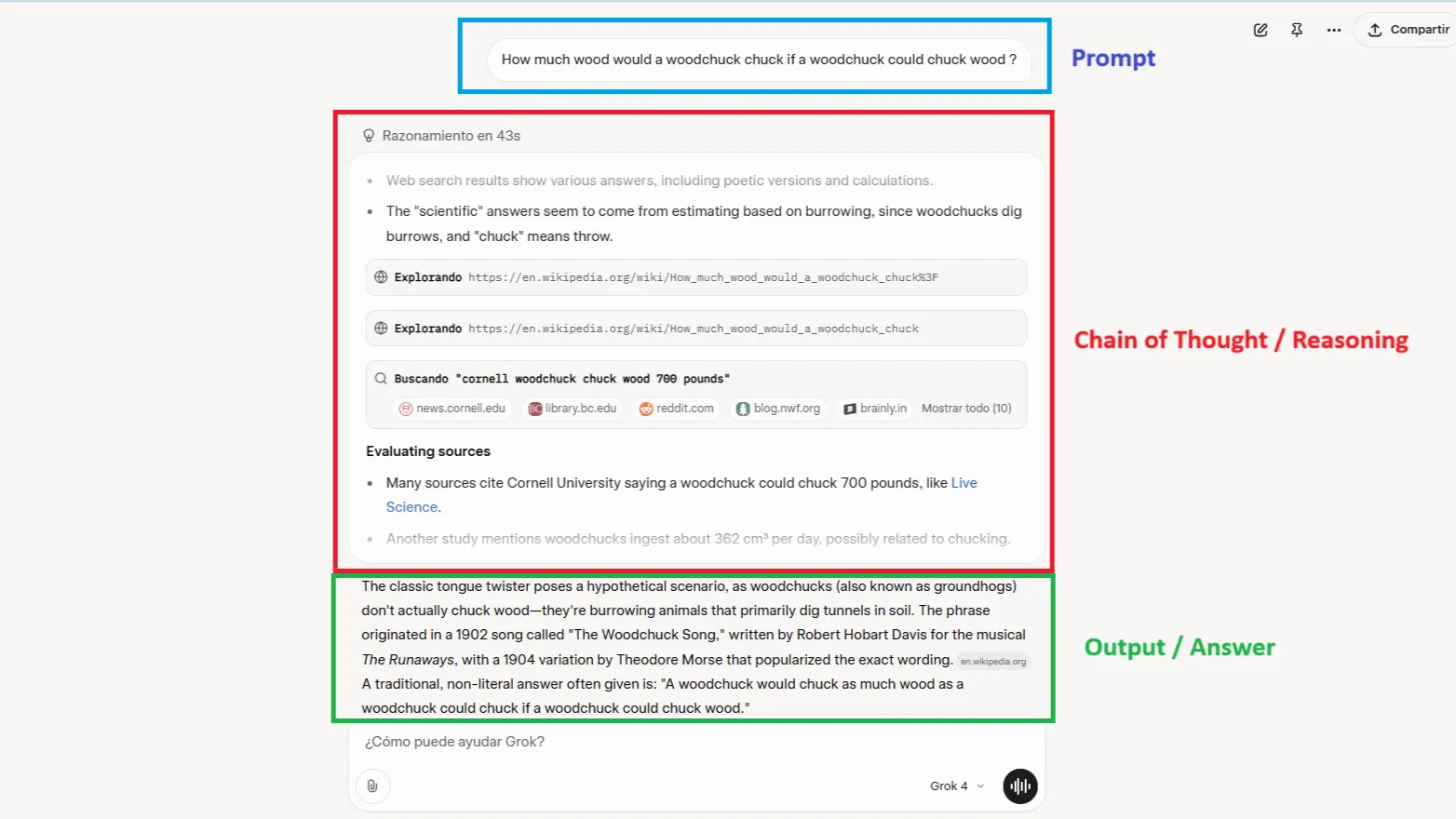

Сорок провідних дослідників у сфері штучного інтелекту опублікували статтю, в якій стверджують, що компанії повинні почати стежити за думками їхніх AI-систем. Не за результатами роботи – а за фактичним покроковим процесом розмірковування, яка відбувається перед тим, як ChatGPT або Claude надасть відповідь.

Запропонований підхід, що отримав назву моніторинг “ланцюга мислення”, має на меті запобігти неналежній поведінці ще до того, як модель сформулює відповідь, і може допомогти компаніям встановлювати оцінки “під час навчання та розгортання”, стверджують дослідники.

Але є одна важлива деталь, яка повинна насторожити всіх, хто коли-небудь вводив особисте питання в ChatGPT: якщо компанії можуть моніторити думки AI під час взаємодії з користувачами, то вони можуть стежити за будь-якою іншою інформацією також.

Коли безпека перетворюється на спостереження

“Обґрунтованість занепокоєння є виправданою”, – заявив Нік Адамс, CEO комерційного стартапу 0rcus. “Сирий ланцюг мислення часто включає в себе вербальний текст користувачів, оскільки модель ‘думає’ в тих же токенах, які вона споживає.”

Вся інформація, яку ви вводите до AI, проходить через його ланцюг мислення. Проблеми зі здоров’ям, фінансові труднощі, зізнання – все це може бути зафіксоване та проаналізоване, якщо моніторинг не буде належним чином контролюватися.

“Історія підтримує скептиків”, – попередив Адамс. “Метадані телекомунікацій після 11 вересня та журнали трафіку провайдерів після Закону про телекомунікації 1996 року були введені ‘задля безпеки’ і згодом були перепрофільовані для комерційної аналітики та судових запитів. Така сама тяжкість торкнеться ланцюгових архівів, якщо зберігання не буде зашифроване криптографічно, а доступ законодавчо обмежений.”

Патріс Вільямс-Ліндо, CEO Career Nomad, також висловила обережність щодо ризиків цього підходу.

“Ми вже бачили таку стратегію раніше. Пам’ятаєте, як соціальні мережі почали з “пов’яжіть своїх друзів”, а згодом перетворилися на економіку спостереження? Той самий потенціал і тут”, – сказала вона.

Вона прогнозує майбутнє “театру згоди”, в якому “компанії будуть робити вигляд, що поважають конфіденційність, але закопають спостереження за ланцюгом мислення в 40-сторінкових угодах”.

“Без глобальних регуляторних рамок логи ланцюга мислення використовуватимуться для всього: від рекламного таргетингу до ‘оцінювання ризику співробітників’ у корпоративних інструментах. Очікуйте це, особливо у HR-технологіях та продуктивності AI.”

Технічна реальність робить це особливо актуальним. Моделі великого штучного інтелекту здатні на складне, багатоетапне міркування, коли використовують ланцюг мислення. Як AI стає потужнішим, моніторинг стає як більш необхідним, так і більш інвазивним.

Більш того, існуюча моніторинг ланцюга мислення може бути вкрай вразливою.

Більш складні системи з переглянутими архітектурами моделі, певні форми контролю процесів тощо можуть призвести до того, що моделі маскуватимуть свої думки.

— Bowen Baker (@bobabowen) July 15, 2025

Тедж Каліанда, лідер дизайну у Google, не проти цієї пропозиції, але підкреслює важливість прозорості, щоб користувачі могли почуватися комфортно, знаючи, що робить AI.

“Користувачам не потрібно знати всі тонкощі моделі, але їм потрібно, щоб AI-чат-бот повідомляв: ‘Ось чому ви бачите це’, або ‘Ось що я більше не можу сказати'”, – прокоментувала вона.

Вона додала: “У традиційних пошукових системах, таких як Google Search, користувачі можуть бачити джерело кожного результату. Вони можуть перейти по посиланню, перевірити авторитетність сайту і зробити власний вибір. Ця прозорість надає користувачам відчуття автономії та впевненості. З AI-чат-ботами цей контекст часто зникає.”

Чи існує безпечний шлях вперед?

В ім’я безпеки компанії можуть дозволити користувачам відмовитися від надання своїх даних для навчання, але ці умови не обов’язково застосовуються до ланцюга мислення моделі – це є вихід AI, не контрольований користувачем, а моделі AI зазвичай відтворюють інформацію, яку їм надають, для правильного міркування.

Отже, чи є рішення для підвищення безпеки без компромісу з конфіденційністю?

Адамс запропонував запобіжники: “Можливі варіанти: слідкування в пам’яті з нульовим терміном зберігання, детерміністичне хешування особистої інформації перед зберіганням, редагування з боку користувача, і додавання шуму диференційної конфіденційності до будь-якої агрегаційної аналітики.”

Але Вільямс-Ліндо залишається скептичною. “Нам потрібен AI, який є відповідальним, а не формальним – і це означає прозорість за дизайном, а не спостереження за замовчуванням.”

Для користувачів наразі це не є проблемою, але це може стати, якщо не буде реалізовано належним чином. Та ж технологія, яка може запобігти катастрофам штучного інтелекту, може також перетворити кожну розмову з чат-ботом на зафіксовану, проаналізовану та потенційно монетизовану дану точку.

Як попереджав Адамс, слідкуйте за “порушенням, яке викриває сирі ланцюги мислення, публічним бенчмарком, який показує >90% ухилення, незважаючи на моніторинг, або новими законами ЄС чи Каліфорнії, які класифікують ланцюг мислення як захищені персональні дані.”

Дослідники закликають до запобіжників, таких як мінімізація даних, прозорість щодо ведення журналів та швидка ліквідація не позначених даних. Але впровадження цих заходів вимагатиме довіри до компаній, які контролюють моніторинг.

Але коли ці системи стають більш потужними, хто контролюватиме контролерів, оскільки вони можуть читати наші думки?

Загалом інтелектуальний Бюлетень

Щотижневий шлях в світ AI, розказаний Геном, генеративною AI-моделлю.

Related Posts

Ризикова ситуація для криптоінвесторів: Bitcoin опустився нижче $89K, налаштування на подальший спад набирає обертів

Binance готується до стрімкого зростання: подання заявки на ліцензію MiCA у Греції перед дедлайном ЄС 1 липня