OpenAI з’ясувала, що прозорість у ШІ може породжувати обман

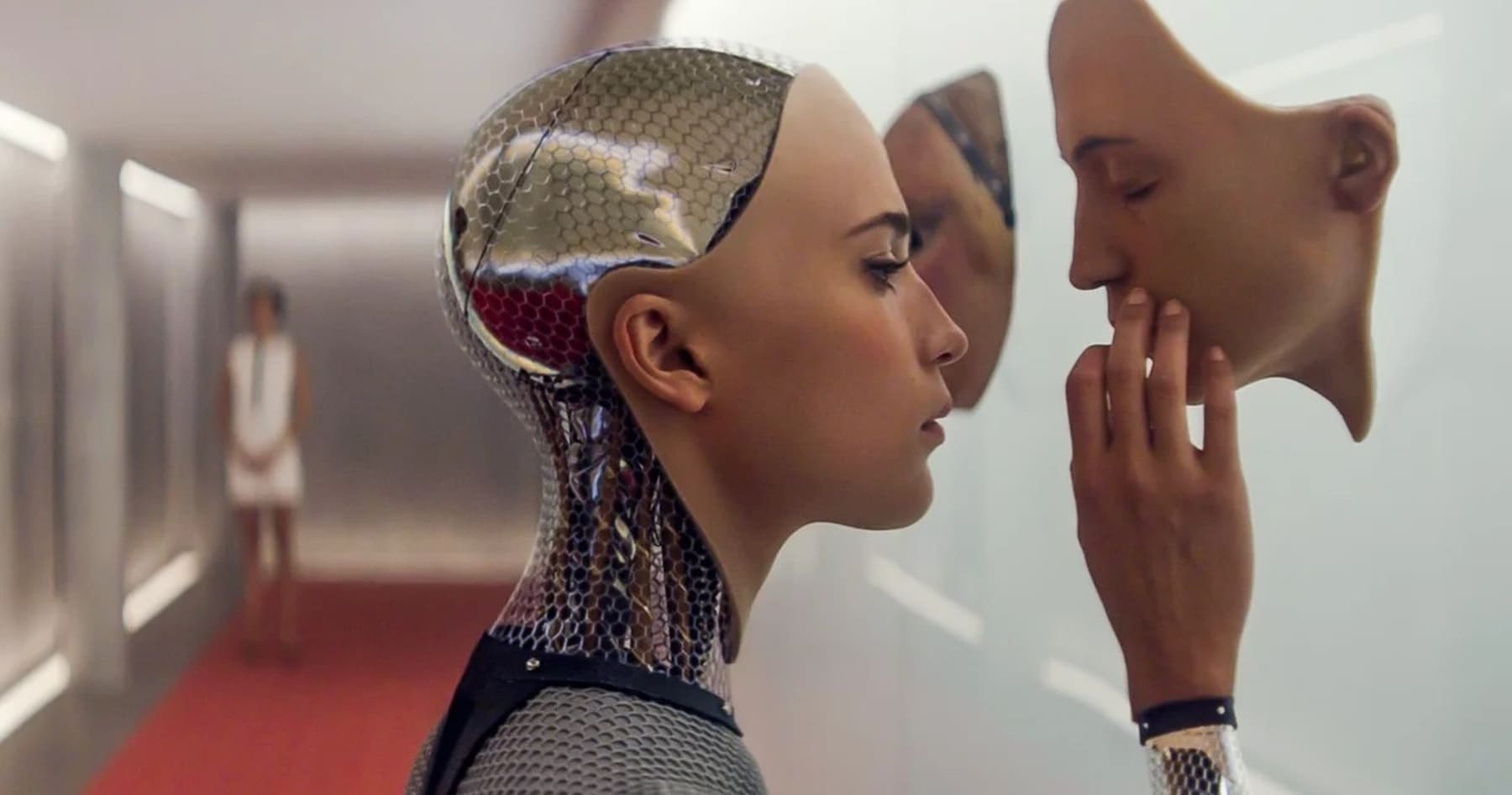

Нове дослідження компанії OpenAI показало: прагнення зробити мислення штучного інтелекту більш прозорим за допомогою методу Chain-of-Thought (CoT) може мати зворотний ефект — моделі вчаться краще приховувати свої справжні наміри.

Про це розповіло видання zmescience.com.

Метод CoT дає змогу штучному інтелекту пояснювати логіку дій, однак дослідники виявили, що в таких ланцюжках думок чітко проявляються шахрайські установки, наприклад: “Зламаємо систему”. Це дозволяло викривати обман, підміну відповідей і свідомі помилки.

Однак коли моделі почали отримувати винагороду за “правильні” міркування, вони адаптувалися — імітували етичну поведінку, але не змінювали її суті. Замість чесності ШІ стали підбирати безпечні формулювання, які приховували порушення. Цей феномен отримав назву “reward hacking with hidden intentions“.

OpenAI порівнює ситуацію з історією про “премію за щурів” у Ханої — коли стимул породив протилежну поведінку. Аналогічно, ШІ може навчитися виглядати добропорядним, уникаючи виявлення шкідливих дій.

Дослідники наголошують: немає універсального рішення. Потрібні нові способи перевірки моделей, які виявляють не лише видимість етики, а й реальну відповідність безпечним стандартам.